我是LeePoet。今天给大家推荐一款我最近深度体验的ComfyUI节点——ComfyUI-HYPIR,这是一个基于HYPIR项目开发的图像修复工具,专门针对SD2.1模型进行了优化,能够实现高质量的图像修复和超分辨率放大。该技术基于扩散模型生成的分数先验进行图像修复与放大,具有高质量、清晰、锐利的效果。

💡 为什么选择HYPIR?

HYPIR(Harnessing Diffusion-Yielded Score Priors for Image Restoration)是一个利用扩散模型得分先验进行图像修复的先进技术。相比传统的ESRGAN放大方式,HYPIR在细节保留和伪影控制方面表现更出色,特别适合处理模糊、噪点严重的图像。

🎯 适用场景

ComfyUI-HYPIR几乎覆盖了所有图像修复需求:

- 老照片修复:将模糊的老照片恢复到高清状态

- 商品图优化:电商产品图放大后依然保持清晰细节

- 动漫/游戏素材:二次元图片放大后线条清晰,色彩饱满

- 人像写真:针对人像照片进行专项优化,面部细节更自然

- 风景照片:自然风光放大后远景细节依然丰富

HYPIR可在GitHub上找到,推荐使用其ComfyUI插件实现,模型需下载并放置于ComfyUI的models文件夹中。操作流程包括单张图片上传、设置放大倍数(支持1-8倍,推荐2-4倍),并通过HYPIR Advanced节点进行处理。放大前后对比,HYPIR在不改变原图结构的前提下显著提升清晰度。此外,支持批量处理,通过设置路径和数量实现多图自动放大。参数方面,coeff值(默认100,可调至500)影响修复强度,数值越高重绘幅度越大,适用于AI生成图像的增强处理。整体流程稳定、操作简便,建议替代旧有放大方法。

开源地址:https://github.com/11dogzi/Comfyui-HYPIR

这是一个用于 HYPIR(利用扩散得分先验进行图像修复) 的 ComfyUI 插件,HYPIR 是基于 Stable Diffusion 2.1 的先进图像修复模型。

功能特性

- 图像修复:利用扩散先验修复和增强低质量图像

- 批量处理:一次处理多张图片

- 高级控制:可微调模型参数以获得最佳效果

- 模型管理:高效加载和复用 HYPIR 模型

- 放大功能:内置放大功能(1x 到 8x)

安装方法

1. 安装插件

将本文件夹放入 ComfyUI 的 custom_nodes 目录下:ComfyUI/custom_nodes/Comfyui-HYPIR/

2. 安装 HYPIR 依赖

进入 HYPIR 文件夹并安装所需依赖:

cd ComfyUI/custom_nodes/Comfyui-HYPIR/HYPIR pip install -r requirements.txt

3. 模型下载(自动)

HYPIR 模型

修复模型将下载到:ComfyUI/models/HYPIR/HYPIR_sd2.pth

基础模型(Stable Diffusion 2.1)

基础 Stable Diffusion 2.1 模型将在需要时自动下载到:ComfyUI/models/HYPIR/stable-diffusion-2-1-base/

手动下载(可选):

HYPIR 模型:如果你希望手动下载,可以从以下地址获取 HYPIR 模型:

- HuggingFace: HYPIR_sd2.pth

- OpenXLab: HYPIR_sd2.pth

请将 HYPIR_sd2.pth 文件放在以下任一位置:

- 插件目录:

ComfyUI/custom_nodes/Comfyui-HYPIR/ - ComfyUI 模型目录:

ComfyUI/models/checkpoints/ - 或让插件自动管理,放在

ComfyUI/models/HYPIR/

基础模型: 基础 Stable Diffusion 2.1 模型可从以下地址手动下载:

- HuggingFace:stable-diffusion-2-1-base

请将基础模型放在:ComfyUI/models/HYPIR/stable-diffusion-2-1-base/

注意: 插件会优先在 HYPIR 目录下查找基础模型,如未找到会自动从 HuggingFace 下载。

使用方法

高级图像修复

- 添加 HYPIR Advanced Restoration 节点

- 此节点提供更多参数控制:

model_t:模型步数(默认200)coeff_t:系数步数(默认200)lora_rank:LoRA 阶数(默认256)patch_size:处理块大小(默认512)

配置

你可以在 hypir_config.py 中修改默认设置:

HYPIR_CONFIG = {

"default_weight_path": "HYPIR_sd2.pth",

"default_base_model_path": "stable-diffusion-2-1-base",

"available_base_models": ["stable-diffusion-2-1-base"],

"model_t": 200,

"coeff_t": 200,

"lora_rank": 256,

# ... more settings

}

模型路径管理

插件包含智能模型路径管理:

- HYPIR 模型:自动下载到

ComfyUI/models/HYPIR/HYPIR_sd2.pth - 基础模型:需要时自动下载到

ComfyUI/models/HYPIR/stable-diffusion-2-1-base/ - 本地优先:插件会优先查找本地模型

- 自动下载:仅在本地未找到模型时才下载

最佳效果小贴士

- 提示词:使用与图片内容相符的描述性提示词

- 人像:”high quality portrait, detailed face, sharp features”

- 风景:”high quality landscape, detailed scenery, sharp focus”

- 通用:”high quality, detailed, sharp, clear”

- 放大:

- 1x 表示仅修复不放大

- 2x-4x 适合中等放大

- 8x 为最大放大(速度较慢)

- 参数:

model_t越高(200-500)修复越强coeff_t越高(200-500)增强越明显lora_rank越高(256-512)质量越好(占用更多内存)

- 内存管理:

- 如遇内存不足可用较小的

patch_size(256-512) - 分批处理图片

- 使用模型加载器节点避免重复加载模型

- 如遇内存不足可用较小的

配置

你可以在 hypir_config.py 中修改默认设置:

HYPIR_CONFIG = {

"default_weight_path": "HYPIR_sd2.pth",

"default_base_model_path": "stable-diffusion-2-1-base",

"available_base_models": ["stable-diffusion-2-1-base"],

"model_t": 200,

"coeff_t": 200,

"lora_rank": 256,

# ... more settings

}

模型路径管理

The plugin includes intelligent model path management: 插件包含智能模型路径管理:

- HYPIR Model: Automatically downloaded to

ComfyUI/models/HYPIR/HYPIR_sd2.pth - HYPIR 模型:自动下载到

ComfyUI/models/HYPIR/HYPIR_sd2.pth - Base Model: Automatically downloaded to

ComfyUI/models/HYPIR/stable-diffusion-2-1-base/when needed - 基础模型:需要时自动下载到

ComfyUI/models/HYPIR/stable-diffusion-2-1-base/ - Local Priority: The plugin checks for local models first before downloading

- 本地优先:插件会优先查找本地模型

- Automatic Download: Only downloads when models are not found locally

- 自动下载:仅在本地未找到模型时才下载

最佳效果小贴士

使用模型加载器节点避免重复加载模型

提示词:使用与图片内容相符的描述性提示词

人像:”high quality portrait, detailed face, sharp features”

风景:”high quality landscape, detailed scenery, sharp focus”

通用:”high quality, detailed, sharp, clear”

放大:

1x 表示仅修复不放大

2x-4x 适合中等放大

8x 为最大放大(速度较慢)

参数:

model_t 越高(200-500)修复越强

coeff_t 越高(200-500)增强越明显

lora_rank 越高(256-512)质量越好(占用更多内存)

内存管理:

如遇内存不足可用较小的 patch_size(256-512)

分批处理图片

常见问题

- 导入错误:请确保已安装 HYPIR 依赖cd HYPIR pip install -r requirements.txt

- 模型未找到:插件会自动下载缺失的模型

- 检查网络连接以便自动下载

- HYPIR 模型:将

HYPIR_sd2.pth放在插件目录或 ComfyUI 模型目录 - 基础模型:将

stable-diffusion-2-1-base文件夹放在ComfyUI/models/HYPIR/ - 插件会自动检查并下载缺失模型

实操:

1.先到https://github.com/11dogzi/Comfyui-HYPIR的仓库直接复制插件仓库地址

2.进入本地的.\ComfyUI\custom_nodes目录,右链git bash拉取仓库

3.启动COMFYUI,通过启动器先拉取HYPIR所需要的库并启动到UI

4.打开huggingface.co,直接使用国内镜像源:https://huggingface.1319lm.top/lxq007/HYPIR/tree/main,复制HYPIR的GIT仓库

5.下载HYPIR修复模型,进入.\ComfyUI\models,右键打开git bash,魔法就使用国内镜像源GIT

6.下载stable-diffusion-2-1-base模型,先进入https://huggingface.1319lm.top/Manojb/stable-diffusion-2-1-base/tree/main,把以下红框框住的都手动下载,因为很多都是重复的一样的模型,只是后缀不一样。我们只需要下一个就行。所以这里不能直接GIT整个仓库。

额外说明:text_encoder、unet、vae都只需要下一个模型即可,如果是FP16的,下载到本地后记得把FP16的字去掉,这样才会被节点识别。

7.下载完所有模型后,重新启动COMFYUI

当然,SD放大的模型与技术有很多,可以说都各有千秋,非要说哪几个最好用,只有等LEEPOET闲来有空再给大家介绍,总而言之ComfyUI-HYPIR是一款功能强大、操作简单的图像修复工具,特别适合需要高质量图像放大的用户。无论是老照片修复、商品图优化还是人像写真处理,都能获得令人满意的效果。如果你正在寻找一款稳定、高效的图像超清修复工具,ComfyUI-HYPIR绝对值得一试。我已经将它作为我的主力图像修复工具,强烈推荐给大家!

相关文章:

ComfyUI-GGUF-VLM 结合 llama.cpp GPU 加速:实现图像反推秒级效率

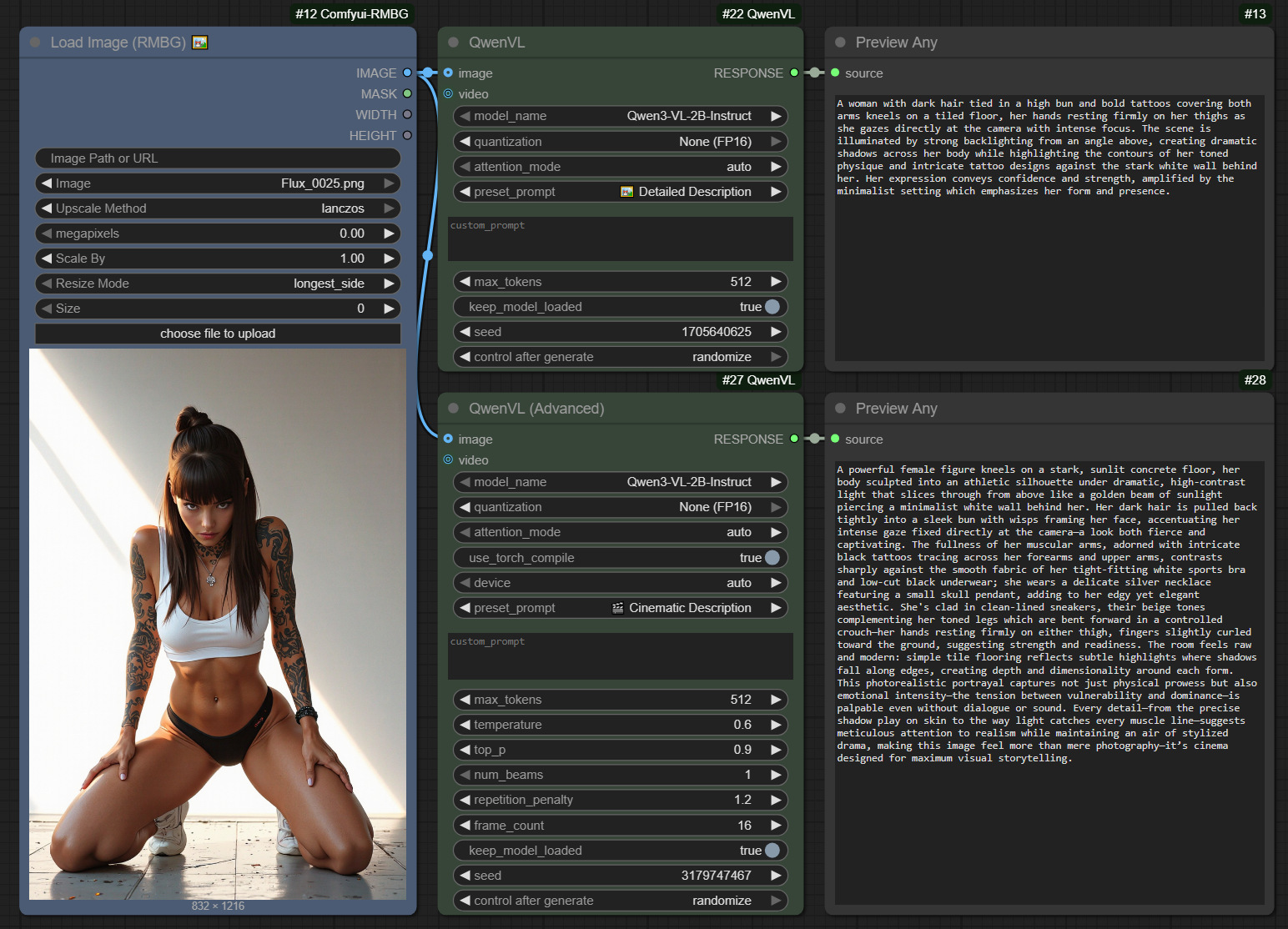

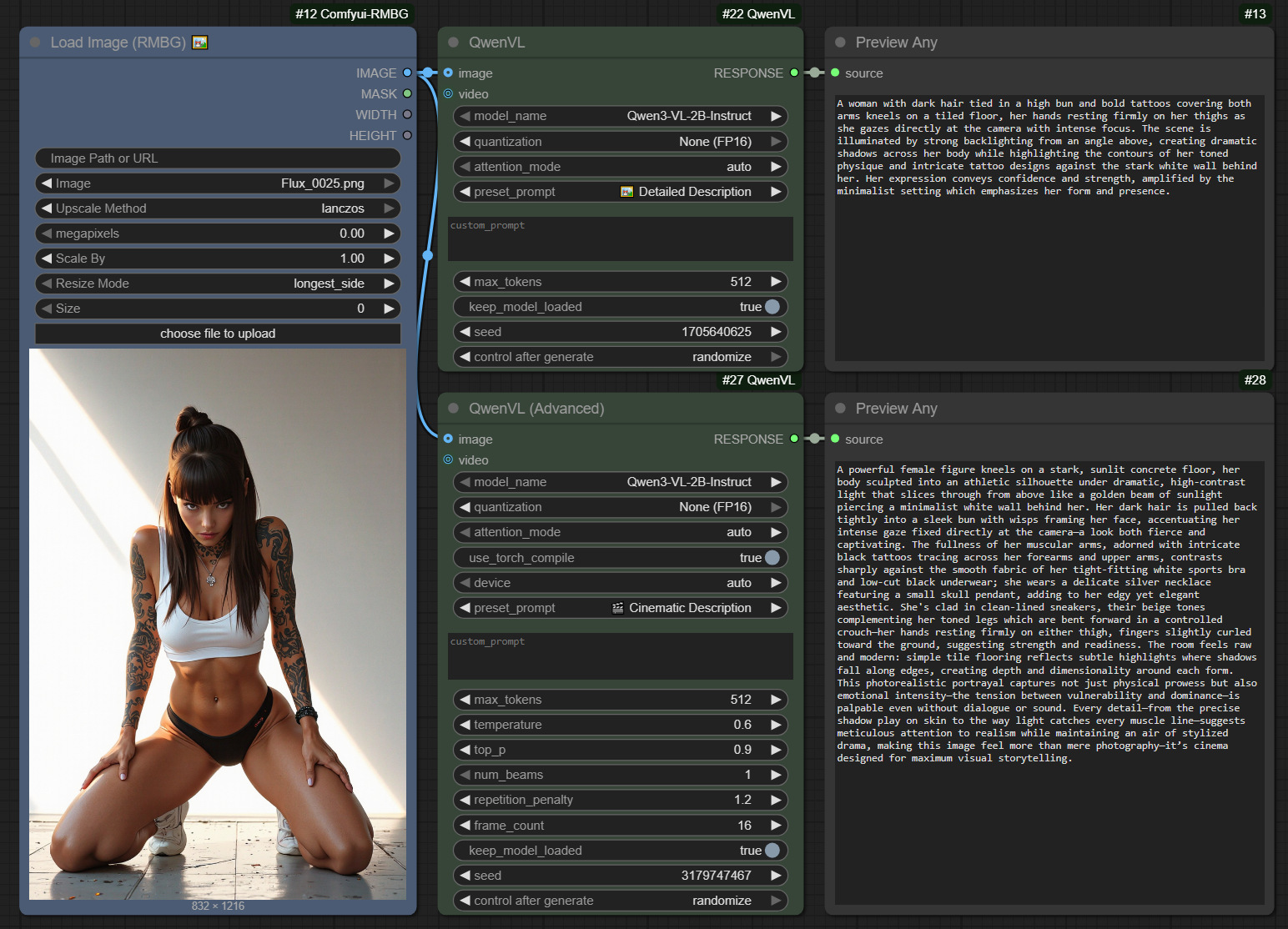

Custom_Nodes篇:ComfyUI-QwenVL反推节点

Custom_Nodes篇:ComfyUI-QwenVL3-image反推节点