AI发烧友们,大家好!最近是不是感觉哪里都在谈“智能体(Agent)”?从自动编程到智能决策,它俨然成了AI界的新晋“顶流”。但面对海量信息,你是否也曾感到无从下手:教程太浅、门槛太高,想亲手实践却找不到合适的项目?别担心!今天,我们就为大家精选了GitHub上10个高星智能体开源项目,涵盖从通用框架到垂直工具,从单机作战到多体协同,并附上保姆级介绍与实战指南。收藏这篇文章,你的智能体学习之路将事半功倍!

智能体是什么?为什么它值得关注?

简单来说,智能体是一个“会独立思考、自主行动的AI助手”。你只需给定一个目标,它便能自主规划任务、调用工具、执行步骤,甚至与其他智能体协同完成复杂工作。目前,智能体已广泛应用于科研、办公、游戏开发等领域。而开源项目,正是我们快速入门的“捷径”——无需从零造轮子,基于成熟代码稍作修改,你就能打造属于自己的智能体,高效又实用!

先唠两句:啥是智能体?为啥要学?

说白了,智能体就是“能自己干活的AI助手”——给它个目标,它会自己拆解任务、调用工具、调整策略,甚至和其他AI“组队打工”。现在从科研、办公到游戏、机器人,到处都能看到它的身影。而开源项目就是咱普通人的“快车道”:不用从零造轮子,直接改改代码就能搭自己的智能体,香到不行!

10个必玩智能体开源项目,按头安利!

1. AutoGPT:智能体界的“开山网红”

介绍:当年一句“AI自主完成任务”直接引爆GitHub的狠角色!基于GPT模型,能自己规划、搜索、执行任务,堪称“AI版自动化脚本”。

10个项目横向对比表(选项目不纠结!)

| 项目名 | 核心优势 | 适用人群 | 技术门槛 | 部署难度 | 最佳场景 |

|---|---|---|---|---|---|

| AutoGPT | 入门简单,自主性强 | 新手、小白 | 低 | 易 | 简单任务自动化 |

| MetaGPT | 分工清晰,输出质量高 | 开发者、产品 | 中 | 中 | 软件开发、项目规划 |

| LangChain | 万能工具箱,兼容性强 | 全阶段开发者 | 中 | 易 | 自定义智能体开发 |

| AutoGen | 多智能体协作,微软背书 | 进阶开发者 | 中高 | 中 | 复杂决策、团队协作 |

| BabyAGI | 代码极简,原理清晰 | 学习者、新手 | 低 | 易 | 理解智能体逻辑 |

| HuggingGPT | 多模型联合,成本低 | 开发者、研究者 | 中高 | 中高 | 多模态任务、本地部署 |

| AgentGPT | 零代码,网页直接用 | 纯新手、体验党 | 无 | 无 | 快速测试、简单任务 |

| GPT-Researcher | 学术向专业,文献整理 | 学生、研究员 | 低 | 易 | 论文写作、文献综述 |

| CrewAI | 团队管理逻辑强 | 项目管理者 | 中 | 中 | 多角色协作、复杂任务 |

| AgentQL | 自然语言查数据 | 业务、数据岗 | 低 | 易 | 数据分析、报表生成 |

主要功能:

- 自主拆解复杂任务(比如“写一篇AI发展报告”→ 拆成查资料、整理数据、写初稿、润色)

- 调用搜索引擎、文件工具,甚至控制其他软件

- 支持自定义目标和规则,灵活性拉满

应用场景:自动写报告、数据整理、批量处理文件、简单的科研辅助

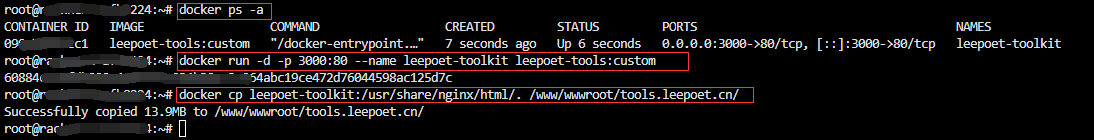

部署方法:

- 克隆仓库:

git clone https://github.com/Significant-Gravitas/AutoGPT.git - 安装依赖:

pip install -r requirements.txt - 配置OpenAI API密钥和目标,运行

python -m autogpt即可

亮点&小槽点:入门简单,适合新手练手;但偶尔会“钻牛角尖”,需要手动干预调整目标。

GitHub链接:https://github.com/Significant-Gravitas/AutoGPT

2. MetaGPT:多智能体“职场协作”神器

介绍:由国内团队开发的“全流程智能体框架”,核心是模拟“职场团队分工”——比如产品经理、开发、测试各司其职,合力完成项目。

主要功能:

- 内置“角色分工”系统:支持产品经理(提需求)、架构师(画方案)、开发(写代码)等角色

- 自动生成文档、代码、测试用例,甚至能输出项目计划

- 多智能体实时沟通协作,像真人团队一样推进任务

应用场景:小型软件开发、项目规划、团队协作流程模拟、创业项目原型设计

部署方法:

- 克隆仓库:

git clone https://github.com/geekan/MetaGPT.git - 安装依赖:

pip install -r requirements.txt - 配置API密钥,输入需求(比如“开发一个贪吃蛇游戏”),运行

python startup.py "你的需求"

亮点&小槽点:分工超清晰,输出质量高;但对硬件和API额度要求稍高,新手可能需要先调参。

GitHub链接:https://github.com/geekan/MetaGPT

3. LangChain:智能体的“工具箱”(必学!)

介绍:虽然不算纯智能体,但绝对是构建智能体的“基础设施”!把各种AI模型、工具、数据串起来,让你轻松搭出复杂智能体。

主要功能:

- 集成主流大模型(GPT、LLaMA、文心一言等)和工具(搜索、数据库、API调用)

- 提供“记忆模块”:让智能体记住对话历史和任务状态

- 支持“链(Chain)”和“智能体(Agent)”两种模式,灵活组合功能

应用场景:自定义智能体开发、聊天机器人、知识库问答、数据分析助手

部署方法:

- 直接安装库:

pip install langchain - 搭配具体模型(如OpenAI):

pip install openai - 参考文档写代码:定义工具→设置智能体→调用执行

亮点&小槽点:兼容性超强,几乎所有智能体项目都绕不开它;但需要点代码基础,纯小白可能要先补Python。

GitHub链接:https://github.com/langchain-ai/langchain

4. AutoGen:微软出品的“智能体协作平台”

介绍:微软研究院开源的多智能体框架,主打“让多个AI智能体聊天协作”,甚至能和人类实时互动,解决复杂问题。

主要功能:

- 支持“智能体-智能体”“智能体-人类”混合协作

- 自动分配任务、调用工具,还能辩论优化方案(比如两个智能体吵架改代码哈哈)

- 兼容多种大模型,支持本地部署(不用依赖OpenAI)

应用场景:复杂决策、代码审查、学术研究协作、多人任务分配

部署方法:

- 安装:

pip install pyautogen - 写配置文件:定义智能体角色、模型、工具权限

- 启动对话:

python your_script.py让智能体们开始“打工”

亮点&小槽点:微软背书,稳定性强;协作逻辑超灵活,但配置稍复杂,建议先看官方示例。

GitHub链接:https://github.com/microsoft/autogen

5. BabyAGI:极简任务智能体

介绍:名字萌但功能硬核!用不到200行代码实现“目标-任务-执行”闭环,适合新手理解智能体核心逻辑。

主要功能:

- 核心逻辑:设定目标→生成任务→执行任务→更新任务列表

- 支持用向量数据库存储任务记忆,避免重复劳动

- 可自定义执行工具(比如加个网页爬虫、计算器)

应用场景:学习智能体原理、搭建轻量任务助手(如定时查天气、整理邮件)

部署方法:

- 克隆仓库:

git clone https://github.com/yoheinakajima/babyagi.git - 安装依赖:

pip install -r requirements.txt - 配置OpenAI和向量数据库密钥,运行

python babyagi.py输入目标

亮点&小槽点:代码极简,新手能看懂;但功能基础,复杂任务需要自己加工具。

GitHub链接:https://github.com/yoheinakajima/babyagi.git

6. HuggingGPT: Hugging Face+GPT的“强强联合”

介绍:浙大团队开源的“大模型调度官”!让GPT当“指挥官”,调用Hugging Face上的1000+开源模型干活,成本低还强。

主要功能:

- GPT负责拆解任务、选模型,Hugging Face模型负责具体执行(如图像识别、翻译、代码生成)

- 支持文本、图像、语音等多模态任务,全能选手

- 本地部署可选,不用完全依赖API

应用场景:多模态任务处理(如“给图片写文案+翻译”)、低成本智能体开发

部署方法:

- 克隆仓库:

git clone https://github.com/microsoft/HuggingGPT.git - 安装依赖:

pip install -r requirements.txt - 配置OpenAI和Hugging Face密钥,运行示例脚本

亮点&小槽点:模型资源丰富,成本可控;但对设备算力有要求,本地跑大模型可能卡。

GitHub链接:https://github.com/microsoft/HuggingGPT

7. AgentGPT:浏览器直接玩的“零代码智能体”

介绍:懒人福音!不用装环境,打开网页就能创建智能体,输入目标直接跑,新手友好度拉满。

主要功能:

- 网页端可视化操作,填个目标就能启动智能体

- 实时显示任务拆解和执行过程,像“看AI打工直播”

- 支持保存历史记录,随时复盘调整

应用场景:快速测试智能体效果、新手入门体验、简单任务自动化(如写提纲、查信息)

部署方法:

- 直接用在线版:https://agentgpt.reworkd.ai/(偶尔需要排队)

- 本地部署:克隆仓库后按文档配置Next.js环境,启动即可

亮点&小槽点:零代码门槛,谁都能玩;但功能有限,复杂任务还是得用本地项目。

GitHub链接:https://github.com/reworkd/AgentGPT

8. GPT-Researcher:学术党狂喜的“论文助手”

介绍:专注“学术研究”的智能体!输入研究主题,自动搜文献、读论文、整理观点,还能生成带引用的报告。

主要功能:

- 自动搜索学术数据库(Google Scholar、Arxiv等)和权威来源

- 提取核心观点、对比不同研究,生成结构化报告(带参考文献格式)

- 支持自定义研究深度和报告风格(如摘要、综述、批判性分析)

应用场景:写论文查资料、文献综述、快速了解研究领域进展

部署方法:

- 克隆仓库:

git clone https://github.com/assafelovic/gpt-researcher.git - 安装依赖:

pip install -r requirements.txt - 配置API密钥,运行

python main.py输入研究主题

亮点&小槽点:学术向超专业,省超多查文献时间;但依赖英文资源,中文文献支持一般。

GitHub链接:https://github.com/assafelovic/gpt-researcher

9. CrewAI:多智能体“团队管理”框架

介绍:把智能体变成“团队成员”,你当“老板”给任务,它自动分配角色、设目标、追进度,主打一个省心。

主要功能:

- 可视化定义角色(如“市场分析师”“文案写手”)、技能和目标

- 智能体间自动沟通协作,遇到问题会“请示”你

- 支持集成各种工具(API、数据库、爬虫)扩展能力

应用场景:内容创作团队、市场调研、项目管理、多步骤任务处理

部署方法:

- 安装库:

pip install crewai - 写代码定义角色、任务和工具

- 启动团队:

crew.kickoff()坐等结果

亮点&小槽点:团队管理逻辑超清晰,适合复杂协作;但文档较少,新手可能需要多试。

GitHub链接:https://github.com/joaomdmoura/crewai

10. AgentQL:智能体+数据库的“数据查询神器”

介绍:让智能体直接“懂数据库”!输入自然语言问题(比如“查下上月销售额前5的产品”),自动生成SQL并查结果。

主要功能:

- 自然语言转SQL,不用学代码也能查数据库

- 支持MySQL、PostgreSQL等主流数据库,兼容性强

- 自动校验SQL正确性,避免查错数据

应用场景:数据分析、业务报表生成、非技术人员查数据

部署方法:

- 安装:

pip install agentql - 连接数据库,配置API密钥

- 用自然语言提问:

agent.query("你的问题")

亮点&小槽点:数据查询超方便,非技术党狂喜;但复杂查询可能需要手动调整SQL。

GitHub链接:https://github.com/AgentQL/agentql